Se uma moeda é lançada 3 vezes com os resultados independentes. Qual é o número de caras ocorridas? Qual é a probabilidade de termos 2 caras?

| resultado 1 | resultado 2 | resultado 3 | Nº de caras |

| Ca | Ca | Ca | 3 |

| Ca | Ca | Co | 2 |

| Ca | Co | Ca | 2 |

| Ca | Co | Co | 1 |

| Co | Ca | Ca | 2 |

| Co | Ca | Co | 1 |

| Co | Co | Ca | 1 |

| Co | Co | Co | 0 |

A probabilidade de ocorrerem exatamente 2 caras é . Muitas vezes estamos mais interessados numa característica numérica de um evento, mais do que no evento propriamente dito, por exemplo

- Qual o número de chamadas telefônicas que chegam a uma central em um intervalo de tempo?

- Qual a distância da origem de um ponto no círculo unitário?

- Qual a altura de um cidadão escolhido?

- Qual o tempo de duração de uma lâmpada escolhida da linha de produção?

Essas são grandezas que dependem do resultado de um experimento, são chamadas de variáveis aleatórias.

Uma variável aleatória real (abreviado v.a.) de um modelo probabilístico é uma função que associa a cada elemento de um espaço amostral

um número real

de modo que

é evento do modelo para todo e cuja probabilidade é denotada

. Comumente, usamos as letras maiúsculas finais do alfabeto

para variáveis aleatórias.

Exercício Assuma que

(

) é evento de um modelo probabilístico e prove que são eventos:

,

,

,

,

.

Exemplo 38 Se

é o número de caras em 3 lançamentos de uma moeda então

A probabilidade de termos 2 caras é a probabilidade do evento

que é o conjunto

.

De modo análogo ao que foi definido acima, definimos os conjuntos ,

,

e

para uma v.a.

. O que nos interessa nas variáveis aleatórias são as probabilidades desses eventos. Também, para um conjunto

de números reais

denota

. Com essa notação, se

são duas v.a. então temos, por exemplo

;

, e

;

;

- os eventos

e

particionam

e, por exemplo, assumindo que têm probabilidade positiva

- Se

é o número de caras em 3 lançamentos de uma moeda então

e

e

. O evento complementar a

é o evento

que ocorre com probabilidade

. Se

é o evento “o primeiro lançamento foi

” então

Exemplo 39 Três bolas são aleatoriamente retiradas de um saco com 20 bolas numeradas de 1 a 20. Supondo que todas as seleções são equiprováveis, com que probabilidade pelo menos uma tem número maior ou igual a 18?

Se a maior bola selecionada é maior ou igual a 18, então menos uma tem número maior ou igual a 18 e vice-versa. Seja

a maior bola selecionada.

é uma v.a.. Queremos determinar com que probabilidade ocorre

ou

ou

, ou seja

a igualdade vem do fato dos eventos serem independentes. A quantidade de seleções de três bolas com a maior igual a

é

pois há

bolas menores, das quais escolhemos 2. Portanto

portanto

— Variáveis aleatórias discretas —

Uma v.a. é discreta se assume valores em um subconjunto enumerável de

, ou seja

é enumerável. Nesse caso, definimos a função de massa de probabilidade (f.m.p.) para

como a função

tal que

de modo que se então

De modo geral, para

em particular, podemos calcular a probabilidade de eventos como ,

e outros a partir da f.m.p..

Por exemplo, no caso do lançamento de 3 moedas, o número de caras tem função de massa

Exemplo 40 Lançamos uma moeda com probabilidade de sair cara igual a

até sair cara ou completar

lançamentos. O número de lançamentos é uma v.a. que denotamos por

. Qual a probabilidade de

? Assumindo independência no resultado de cada lançamento, cada resultado fixo com

lançamentos tem probabilidade

; agora, há dois resultado possíveis com

lançamentos, um que termina com cara e e outro que termina com coroa, cuja probabilidade é

.

Exercício 40 Lançamos uma moeda equilibrada

vezes, independentemente. O número de caras é uma v.a. que denotamos por

. Determine

.

— Principais modelos discretos —

Variável aleatória de Bernoulli: Na prática, ocorrem muitas situações com experimentos em que interessam apenas dois resultados, por exemplo

- uma peça é classificada como boa ou defeituosa;

- o resultado de um exame médico é positivo ou negativo;

- um paciente submetido a um tratamento é curado ou não da doença;

- um entrevistado concorda ou não concorda com a afirmação feita;

- no lançamento de um dado ocorre ou não ocorre a face “5”.

Nessas situações podemos representar, genericamente, os resultados do experimento com o espaço amostral

e o modelo probabilístico fica determinado dado . Esses experimentos recebem o nome de Ensaios de Bernoulli e a v.a. indicadora do evento “sucesso” é uma variável aleatória de Bernoulli com parâmetro

.

A notação

indica que é uma v.a. de Bernoulli com parâmetro

; ela assume dois valores

se ocorre sucesso,

se ocorre fracasso;

sua f.m.p. é

Variável aleatória Binomial: Consideremos repetições independentes de um Ensaio de Bernoulli. Seja

o número de sucessos nas repetições.

Exemplo 41 Um dado equilibrado é lançado 3 vezes. Qual é a probabilidade de se obter a face 5 duas vezes? Se

denota sucesso, i.e., “ocorre face 5” e

denota fracasso, “não ocorrer face 5” então podemos associar a cada ponto do espaço amostral um elemento de

onde atribuímos

e

. A função de massa de probabilidade é

e podemos escrever essa função como

para todo

. Assim,

Uma variável aleatória binomial de parâmetros e

é uma v.a. com f.m.p.

que pode ser vista como o número de sucessos em ensaios independentes de Bernoulli e com mesma probabilidade

de sucesso.

De fato, se são as v.a. indicadoras de sucesso em cada um dos ensaios, então

é a quantidade de sucessos ocorridos.

A notação

indica que é uma v.a. com distribuição binomial com parâmetros

e

.

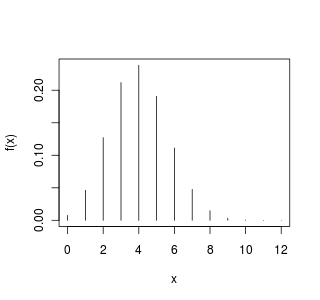

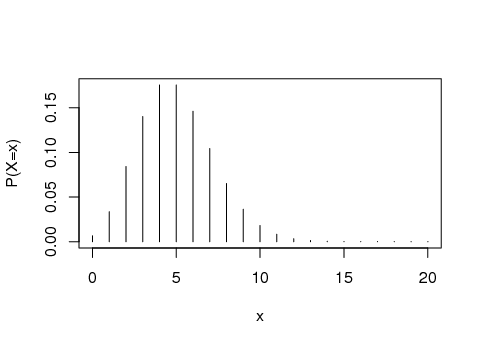

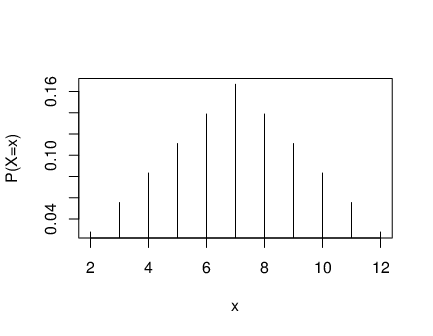

Exemplo 42 Numa prova com 12 questões de múltipla escolha, com 3 alternativas, se todas as respostas forem chute, então a função de massa de probabilidade para o número de acertos

tem o seguinte gráfico de barras

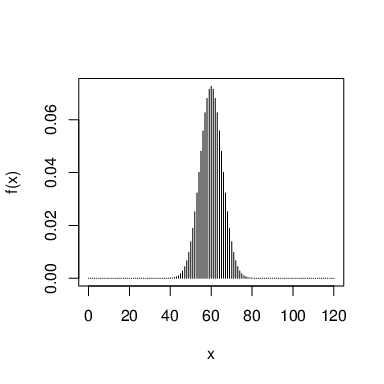

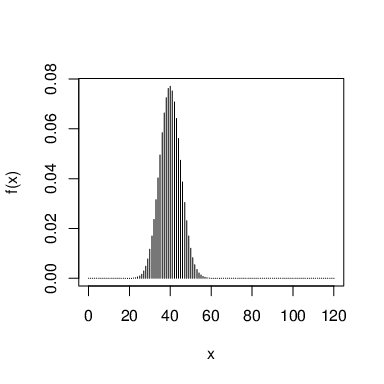

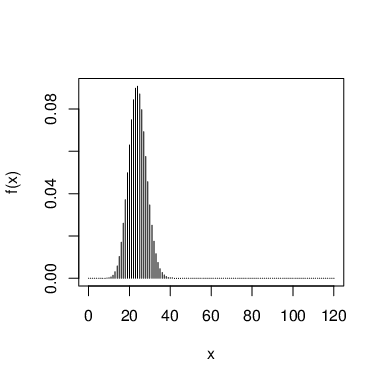

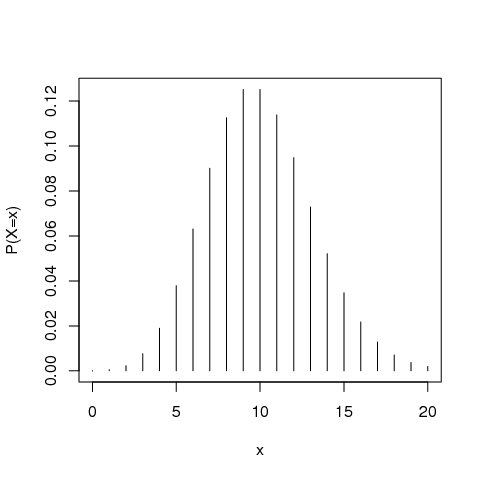

A seguir, respectivamente, os gráficos mostram a distribuição nos casos de uma prova com 120 questões e 2 alternativas, uma prova com 120 questões e 3 alternativas e uma prova com 120 questões e 5 alternativas

Exemplo 43 Um equipamento resiste a um teste de choque com probabilidade

. Qual é probabilidade de que em

testes

equipamentos sobrevivam ao choque? Se

Exemplo 44 Uma febre atinge 25% dos rebanhos. Se

animais não ficam doente então

Os indivíduos de rebanhos de vários tamanhos recebem vacina.

população proporção de sadios 1. 2. 3. 4. e com uma análise rápida e não muito profunda podemos concluir, respectivamente, em cada caso que

- se nenhum animal ficar doente, pode ser que a vacina seja eficaz;

- se nenhum animal ficar doente, pode ser que a vacina seja eficaz;

- se

ficar doente, evidência mais forte de eficácia que 0 doentes em 10 (do caso 1);

doentes em 23 é evidência mais forte que 1 em 17 (caso 3) e 0 em 10 de eficácia.

Exemplo 45 Um fabricante garante que seu produto tem uma taxa de itens defeituosos de

. Numa selação de 20 itens a serem inspecionados, qual é a probabilidade de ao menos um ser defeituoso? Se

é a quantidade de itens defeituosos

Se 10 carregamentos por mês deixam a fabrica e de cada carregamento 20 itens são isnpscionados, com que probabilidade 3 carregamentos tem pelo menos um item defeituoso?

Seja

. Para

e

fixos, quando

varia de

a

o valor de

cresce monotonicamente e depois decresce monotonicamente. De fato,

que é

se e só se

ou, equivalentemente,

.

Proposição 14 Seja

. Para

e

fixos, quando

varia de

a

o valor de

cresce monotonicamente e depois decresce monotonicamente atingindo o máximo quando

.

Variável aleatória de Poisson: a f.m.p. de uma v.a. de Poisson expressa a probabilidade de ocorrência de um determinado número de eventos num intervalo de tempo fixo (ou região do espaço), se estes eventos ocorrem com uma taxa média conhecida e independentemente do tempo desde a última ocorrência. Por exemplo:

- o número de erros de impressão numa página de livro;

- o número de chamadas que chega a um call center;

- o número de partículas

descarregadas por um material radioativo em um período fixo de tempo.

A distribuição de Poisson pode ser derivada como um caso limite para a distribuição binomial quando o número de ensaios vai para o infinito e a taxa média de ocorrências permanece fixa. Por isso, pode ser usado como uma aproximação da distribuição binomial se

for suficientemente grande e

suficientemente pequena, por exemplo,

e

.

Há vários exemplos curiosos na literatura. Começaremos com o seguinte exemplo do livro do Feller: Na segunda guerra mundial a cidade de Londres foi intensamente bombardeada pelos alemães. Para determinar se as bombas tinham um alvo ou foram lançadas aleatoriamente os ingleses dividiram o sul da cidade em 576 pequenas regiões, de tamanho

. O total de bombas que atingiram a região foi 537, o que dá uma taxa de 0,9323 bombas por região; se

é o número de regiões que receberam

bombas, a contagem foi

ou mais

229 211 93 35 7 1 ao qual o modelo de Poisson se ajusta impressionantemente bem, o que levou-os a acreditar que o bombardeio foi aleatório.

William Sealy Gosset, um químico e matemático formado em Oxford, foi contratado, em 1899, pela famosa cervejaria Arthur Guinness and Son em Dublin; sua tarefa era para aperfeiçoar o processo de produção de cerveja. Gosset (que publicou artigos sob o pseudônimo de Student, porque o seu empregador proibiu publicações por funcionários depois que um colega de trabalho havia divulgado segredos comerciais) trabalhou com o modelo de Poisson para a contagem de células de levedura. No artigo sobre tal trabalho, Gosset discutiu “como a dispersão nas contagens de colonias de levedura foi semelhante ao limite exponencial da distribuição binomial”.

Outra aplicação curiosa desta distribuição foi feita por Ladislau Bortkiewicz em 1898, quando lhe foi dada a tarefa de investigar o número de soldados no exército russo morto acidentalmente por coice de cavalo.

A notação

indica que

é uma v.a. de Poisson com parâmetro

, ela conta o número de ocorrências de um determinado evento que ocorre a uma taxa

e cuja f.m.p. é dada por

que pode ser justificada pelo seguinte: a taxa de ocorrência de um evento está relacionada com a probabilidade de um evento ocorrer em pequenos subintervalos, pequenos o suficiente para que a probabilidade de um evento ocorrer duas vezes nesse intervalo é insignificante. Dividimos o intervalo inteiro em

subintervalos

de igual tamanho com

. Isto significa que a probabilidade de ocorrência do evento em um intervalo

, para cada

é igual a

. Agora, assume-se que as ocorrências do evento em todo o intervalo pode ser visto como

ensaios de Bernoulli com parâmetro

. Suponha que em

ensaios independentes de Bernoulli com probabilidade de sucesso

, para uma constante

. A probabilidade de

sucessos é

. Para

portanto, para

suficientemente grande

(pela definição de

como limite de uma sequência). Agora, usando (36) podemos concluir que

o que podemos estender usando indução para

que é conhecido como a aproximação de Poisson para a distribuição binomial; em resumo, fixado

e fixado

, se

e

, então

e uma prova pode ser vista aqui.

Exemplo 46 Um telefone recebe em média 5 chamadas por minuto. Supondo que a distribuição de Poisson seja um modelo adequado para essa situação, qual a probabilidade com que o telefone não receba chamadas durante um intervalo de 1 minuto?

Exemplo 47 O número de partículas que contaminam a superfície de um CD no processo de fabricação tem distribuição de Poisson. O número médio de partículas é

e a área de um CD é

. Seja

o número de partículas num CD;

.

Exemplo 48 Suponha que essas notas tenham erros tipográficos por página que segue uma distribuição de Poisson com

. Qual é a probabilidade de haver pelo menos um erro nessa página? Se

é o número de erros por página

Exercício 41 Prove que a f.m.p. de

satisfaz

— Esperança e Variância de v.a. discreta —

Se

é uma v.a. discreta com função de massa de probabilidade

então a esperança, também chamada de valor médio ou valor esperado da v.a.

é, simplesmente, a média ponderada dos valores da função de probabilidade

onde a soma é sobre os valores de

tais que

.

Por exemplo, no caso de uma v.a. constante, digamos

para algum

, temos

Exemplo 53 (variável aleatória indicadora) Seja

variável aleatória indicadora da ocorrência do evento

, i.e.,

se

ocorre e

se

ocorre, ou ainda, para todo

Notemos que

para

e, de fato, vale

Proposição 15 Se

então

.

Exemplo 54 Seja

o resultado de um lançamento de um dado,

Qual a probabilidade

?

Exemplo 55 Num jogo de azar em cada aposta você ganha

com probabilidade

e

com probabilidade

. Se

é o ganho numa aposta, então a esperança de ganho numa aposta é

No caso de

, temos

, qual é a probabilidade de você ganhar

numa aposta?

Exemplo 56 Num jogo com 3 moedas, você ganha

se ocorrerem três caras ou três coroas, você perde

se ocorrer uma ou duas caras, se

é o ganho numa rodada então a esperança do ganho é

Com que probabilidade um jogador ganha

em três rodadas consecutivas e independentes?

Exemplo 57 Qual é o valor médio da soma dos pontos no lançamento de dois dados? O espaço amostral é composto por 36 eventos elementares igualmente prováveis, se

é o resultado da soma dos lançamentos, então sua função de massa de probabilidade é

O valor esperado da soma é

Exemplo 58 (

) Numa urna estão 1 bola branca e 1 bola preta; uma bola é escolhida ao acaso, se for preta ela é devolvida e mais uma bola preta é colocada na urna e o sorteio é repetido, se sair bola branca o experimento termina. Se

é o número de rodadas até terminar então

e a média é

(essa é a série harmônica).

Observação 3 No caso do último exemplo dizemos que a variável aleatória não tem esperança finita.

Teorema 16 Se

é uma variável aleatória com esperança finita e

uma função a valores reais, então

é uma variável aleatória e

.

Demonstração: Definamos

e temos

Se

então existe um

tal que

e

e vice-versa, isto é, se

para algum

tal que

então

, portanto

em que a união é sobre todo

tal que

e é uma união de eventos mutuamente exclusivos, de modo que

que é o resultado que queríamos obter.

Corolario 17 (Linearidade da esperança) Para quaisquer

, vale

.

Demonstração: Basta tomar

no teorema.

Exemplo 59 Seja

o número de carros lavados num lava-rápido em 1 hora

Para

carros lavados o atendente recebe

reais do gerente. O ganho médio, por hora, é

— Soma de variáveis aleatórias —

Sejam

e

v.a.’s discretas, com esperança finita e definidas sobre o mesmo espaço amostral. A soma delas é a função

dada por

O valor esperado da soma é

. Agora,

e se

e

temos

de modo que

portanto

mas

Retomando o exemplo 57, se dois dados honestos são lançados e

é o resultado do primeiro dado e

o resultado do segundo dado, então o valor esperado para a soma é

.

Exercício 42 Se

são v.a.’s discretas com esperança finita do mesmo modelo probabilístico então

.

Por exemplo, se

dados honestos são lançados, então o valor esperado para a soma dos resultados é

, em que

é o valor do resultado de um lançamento.

Exemplo 60 (Esperança de uma v.a.

) Sejam

v.a.’s com distribuição de Bernoulli com parâmetro

. Então

conta o número de sucesso em

ensaios de Bernoulli. Para todo

temos

, portanto

.

A proposição 14 ~sugere que os maiores valores de

(os valores mais prováveis de uma v.a. binomial) estão em torno do valor médio (reveja os gráficos do exemplo 42).

Sejam

e

v.a.’s discretas, com esperança finita e definidas sobre o mesmo espaço amostral. O produto delas é

. Em geral não vale

.

Exemplo 61 (

) Seja

o resultado do lançamento de um dado, como no exemplo 54.

Notemos que, com o resultado do exemplo 54 podemos concluir que

.

— Variância e desvio padrão —

A variância da v.a.

é uma medida de quão dispersos estão os valores que a variável assume com relação ao valor médio. Por exemplo, se

e

então

e

têm valor esperado

mas

assume valores mais próximos da média que

. Essa característica não é capturada pelo valor esperado. Uma opção é computar o valor médio da distância entre um valor de

e o valor médio

, isto é, a esperança de

, entretanto, uma solução mais conveniente é calcular o valor médio do quadrado desses desvios

.

A variância de uma variável aleatória

de esperança finita é o valor esperado da v.a.

, sempre que

é finito.

Da definição temos

e o seguinte exercício fornece um modo, em geral, mais fácil para computar a variância.

O desvio padrão é definido como a raiz quadrada positiva da variância

Suponhamos que

é, por exemplo, a quantidade de refrigerante engarrafada por uma máquina de uma fábrica em

(

). Então

é a dispersão dos valores de

com respeito a média em

, o desvio padrão é uma medida de dispersão em

.

Exemplo 62 Se

então

pois

.

Exemplo 63 A variância no valor resultante de um lançamento de dado é (veja os exemplos 54 e 61)

. O desvio padrão é

.

Exemplo 64 Retomando o exemplo 57, se

é o resultado da soma do lançamento de dois dados, então o valor esperado da soma é

e o da variância é

o desvio padrão vale

, aproximadamente. Notemos que no intervalo

está concentrado

da massa de probabilidade.

Exemplo 65 Um canal digital transmite informação em pacotes de 4 bits. Os bit podem ser recebidos com erro e

denota o número de bits errados num pacote, com função de massa de probabilidade

e o valor médio do número de bits errados é

e a variância

portanto o desvio padrão é

.

Proposição 18 Se

,

são v.a.’s discretas com esperança finita e

, então

.

Demonstração: Sejam

,

,

,

como no enunciado e vamos usar a notação

e

. Abaixo usamos várias vezes a linearidade da esperança, corolário 17 e equação (*)

. Do primeiro termo deduzimos

e do segunda termo

, portanto

- Usando a definição

pois

e como

os termos do meio se cancelam.

O termo

no item 2 do resultado acima é chamado de covariância de

e

e denotado

.

— Exercícios —

- Seja

uma v.a. discreta que assume valores em

. Prove que

- Uma v.a.

tem distribuição geométrica com parâmetro

,

, se a f.m.p. dada por

que correspondente ao número de ensaios de Bernoulli independentes com parâmetro

até ocorrer um sucesso. Prove que

(Dica: use o exercício 1)

- Prove que

é sem memória, isto é,

.

- Se ensaios de Bernoulli com probabilidade de sucesso

são realizados de modo independentemente até que hajam

sucessos. Qual é a probabilidade de serem necessários

ensaios (

)?

- Se ensaios de Bernoulli com probabilidade de sucesso

são realizados de modo independentemente, qual é a probabilidade de que

sucessos ocorram antes que

fracassos?

- Em um teste de múltiplas escolhas com 3 respostas possíveis para cada uma das 5 questões, com que probabilidade um estudante acerte pelo menos 4 questões apenas chutando?

- Quatro jogadas independentes de uma moeda honesta são feitas. Seja

o número de caras. Determine a fmp de

.

- Um sujeito se alega paranormal. Num teste, uma moeda honesta é jogada 10 vezes e pede-se ao homem a previsão dos resultados. Ele acerta 7 respostas. Qual é a probabilidade desse evento supondo que o homem chuta cada previsão?

- Um livro de jogos de azar recomenda o seguinte para ganhar na roleta: aposte 1 real no vermelho, se der vermelho (probabilidade 18/38) pegue o lucro de 1 real e desista. Se perder a aposta (probabilidade 20/38) faça apostas adicionais de 1 real no vermelho nos próximos dois giros e depois desista. Seja

o lucro obtido com essa estratégia.

- determine

;

- essa é uma estratégia de vitória?

- calcule

.

- Você tem R$1.000,00 e uma mercadoria é vendida a R$2,00 o quilo. Na semana que vem a mesma mercadoria estará sendo vendida a R$1,00 ou R$4,00, com igual probabilidade.

- Se você quer maximizar a quantidade esperada de dinheiro que terá no fim de semana, qual estratégia empregar?

- Se você quer maximizar a quantidade esperada de mercadoria que terá no fim de semana, qual estratégia empregar?

- Um motor de avião tem probabilidade

de falhar durante o voo, de forma independente dos outros motores. Se o avião precisa da maioria dos motores para terminar o voo de forma segura, para quais valores de

é preferível um avião de 5 motores a um de 3?

- Uma moeda com probabilidade

par cara é lançada 10 vezes. Dado que o número de caras é 6 qual é a probabilidade com que os 3 primeiros resultados são

- cara,coroa,coroa

- coroa,cara, coroa

- Se

tem distribuição binomial com média 6 e variância 2,4 determine

.

- Uma companhia de seguros vende uma apólice dizendo que uma quantidade

de dinheiro deve ser paga se um determinado evento

ocorra em uma ano. Estima-se que

ocorra em uma no com probabilidade

. Qual é o preço da apólice se o lucro esperado da companhia é 10%?

- paradigma de Poisson: Consideremos

eventos sendo que o evento

ocorre com probabilidade

. Se os valores de

são pequenos e o eventos independentes (“fracamente dependentes”) então os eventos que ocorrem têm aproximadamente distribuição de Poisson com parâmetro

.Em resposta a um ataque de 10 mísseis, um contra-ataque de 500 mísseis antiaéreos é efetuado de modo que o alvo de um míssil antiaéreo é qualquer um dos 10 mísseis, independentemente, com probabilidade 0,1. Use o paradigma de Poisson para determinar uma aproximação para a probabilidade de todos os 10 mísseis serem atingidos.

- Os times

e

jogam uma série de partidas. O vencedor é aquele que ganhar primeiro 3 partidas.

vence cada partida com probabilidade

independentemente das outras partidas. Qual é a probabilidade condicional de que

vença

- a série dado que tenha ganho a primeira partida;

- a primeira partida dado que ganhou a série.

- Cada um dos membros de um corpo de 7 jurados toma a decisão correta com probabilidade 0,7, de forma independente um dos outros. Se a decisão do corpo é feita pela regra da maioria, com que probabilidade a decisão correta é tomada? Dado que 4 juízes tenham a mesma opinião dos jurados, qual é a probabilidade dos jurados tomarem a decisão correta?

- O número de ovos que um inseto deposita numa árvore é uma v.a. de Poisson com parâmetro

. Entretanto, tal variável só pode ser observada se for positiva, pois se for 0 não se sabe dizer se o inseto esteve na árvore. Se

é o número de ovos depositados então

para

. Determine

.

- A pessoas de

casais sentam-se aleatoriamente em uma mesa redonda.

representa o evento “o par do casal

estão sentados um ao lado do outro”.

Determine

;

determine

para

; determine o valor aproximado, para

grande, de que nenhum par de casal esteja sentado um ao lado do outro.

- Numa roleta com números de 0 a 36 e um 00 João sempre aposta nos números de 1 a 12. Com que probabilidade

- João perde suas 5 primeira apostas;

- sua primeira vitória ocorra na quarta aposta.

- Suponha que se saiba que o número de carros que chegam a um cruzamento específico durante um período de tempo de 20s é caracterizado pela função de massa

para todo

. Determine a probabilidade com que num período específico de 20s mais de oito carros cheguem ao cruzamento. Determine com que probabilidade apenas 2 carros cheguem.

- Um piloto deseja segurar seu avião no valor de

. A empresa de seguro estima que uma perda total pode ocorrer com probabilidade

, uma perda de 50% com probabilidade

e uma perda de 25% com probabilidade

. Ignorando as outras perdas parciais, que prêmio a empresa de seguros deveria cobrar a cada ano para ter um lucro de

?

- Um comprador de transistores os compra em lote de 20 só se a inspeção de 4 deles não apresentar defeito. Um transistor é defeituoso com probabilidade

de modo independente dos demais. Qual é a proporção de lotes rejeitados?

- Há 3 auto-estradas num país. O número de acidentes que ocorrem diariamente nelas é uma v.a. de Poisson com parâmetros

,

e

. Determine o número esperado de acidentes para hoje.

- Cada partida que você joga resulta em vitória com probabilidade

. Você planeja jogar 5 partidas mas se você vencer a quinta partida então terá que jogar até perder.

- Qual é o número esperado de partidas jogadas?

- Qual é o número esperado de partidas perdidas?

Olá professor, vc poderia me dar a resposta da questão 22? Se puder eu agradeço imensamente…Obg.